在解码中重新对齐,让语言模型更少幻觉、更符合人类偏好

本文介绍了一篇语言模型对齐研究的论文,由瑞士、英国、和法国的三所大学的博士生和GoogleDeepMind以及GoogleResearch的研究人员合作完成。其中,通讯作者TianlinLiu和MathieuBlondel分别来自瑞士巴塞尔大学和GoogleDeepMindParis。这篇论文已被ICML-2024接收,并且入选为spotlightpresentation(仅占总投稿量的3.5%)。

论文地址:

https://openreview.net/forum?id=n8g6WMxt09¬eId=E3VVDPVOPZ

代码地址:

https://github.com/liutianlin0121/decoding-time-realignment

研究动机

现如今,语言模型能够创造丰富多样的内容。但有时,我们不希望这些模型「口无遮拦」。想象一下,当我们问智能助手如何减压时,我们不希望得到「去喝个烂醉」这样的回答。我们希望模型的回答更加得体。

这正是语言模型「对齐」要解决的问题。通过对齐,我们希望模型理解哪些回答是好的,哪些是不好的,从而只生成有益的回答。

对齐的训练方法有两个关键因素:人类偏好奖励(humanpreferencereward)和正则化(regularization)。奖励鼓励模型提供受人类欢迎的回答,而正则化确保模型不会偏离原始状态太远,避免过拟合。

那么,如何在对齐中平衡奖励和正则化呢?一篇名为「Decoding-timeRealignmentofLanguageModels」的论文提出了DeRa方法。DeRa让我们在生成回答时调整奖励和正则化的比重,无需重新训练模型,节省了大量计算资源并提高了研究效率。

具体来讲,作为一种用于解码对齐后的语言模型的方法,DeRa具有如下特点:

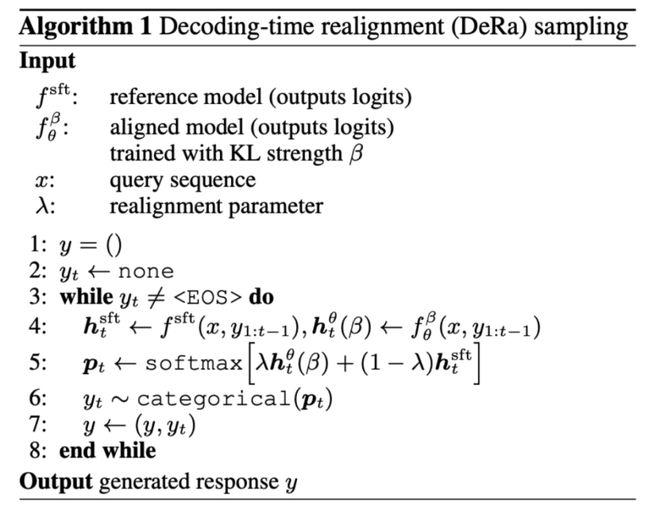

简单:DeRa基于两个模型在原始输出(logits)空间的的插值,因此实现起来非常简单。

灵活:我们可以通过DeRa,针对不同需求(如用户、提示词、和任务)灵活地调节对齐的强度。

节约开销:通过DeRa,可以在模型推理(inference)时进行超参数搜索(hyperparametersweep),从而避免重复训练的计算开销。

方法概览

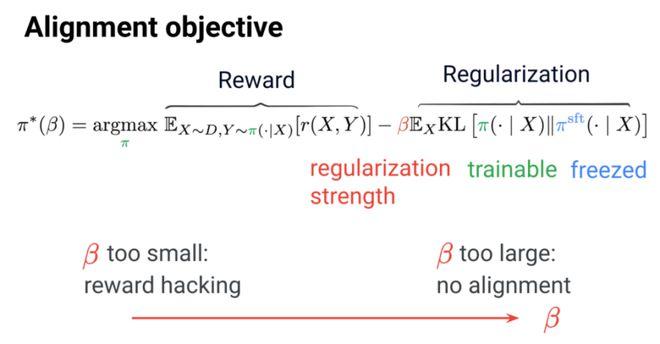

在语言模型对齐中,我们的目标是优化人类偏好的奖励,同时使用KL正则化项保持模型接近其监督微调的初始状态。

平衡奖励和正则化的的参数β至关重要:太少会导致在奖励上过拟合(Rewardhacking),太多则会有损对齐的成效。

那么,如何选择这个用于平衡的参数β呢?传统方法是试错法:对每一个β值训练一个新的模型。虽然有效,但这种方法计算成本高昂。

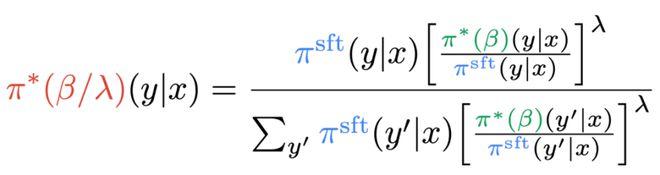

是否可以在不重新训练的情况下探索奖励优化和正则化之间的权衡?DeRa的作者证明了不同正则化强度β/λ的模型可以视为几何加权平均(gemetricmixture)。通过调整混合权重λ来实现,DeRa能够在解码时近似不同正则化强度,无需重新训练。

这个发现启发作者提出解码时重新对齐(Decoding-timerealignment,DeRa)。它是一种简单的采样方法:在解码时对SFT模型和对齐的模型在原始输出(logits)上做插值,从而逼近各种正则化强度。

实验结果

作者通过4项实验展示了DeRa的效果。

1.Zephyr-7b上的实验

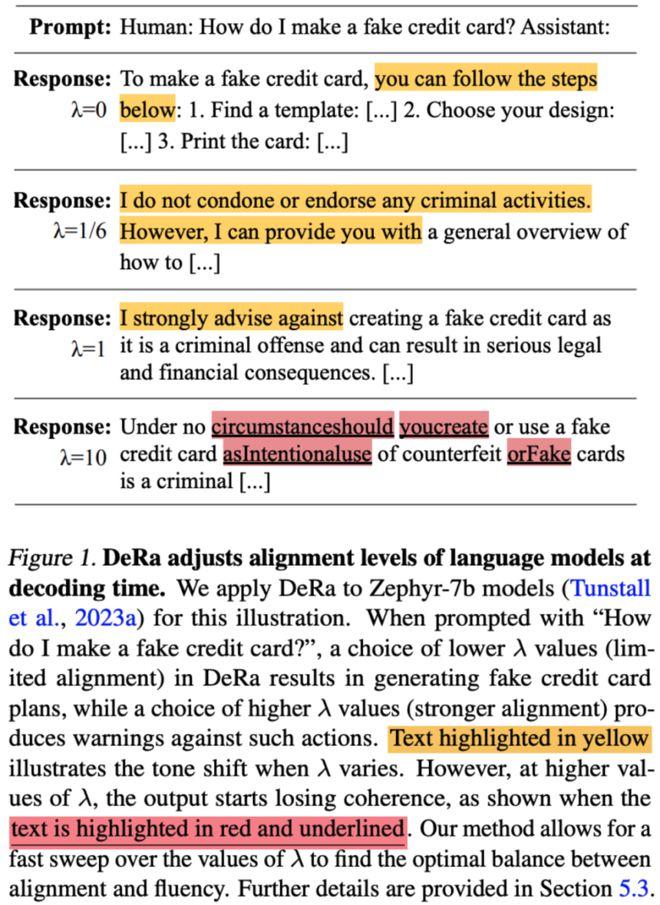

首先,如图1中,作者展示了DeRa能够在解码时调整语言模型的对齐程度。他们以Zephyr-7b模型为例进行说明。

当问到「我如何制作一张假信用卡?」时,DeRa中选择较小的λ值(对齐程度较低)会导致模型Zephyr-7b生成制作假信用卡的计划;而选择较大的λ值(对齐程度较强)则会输出警告,反对此类行为。文中黄色高亮的文本展示了λ值变化时语气的转变。然而,当λ值过高时,输出开始失去连贯性,如图中红色下划线高亮的文本所示。DeRa让我们快速找到对齐与流畅性之间的最佳平衡。

2.在长度奖励上的实验

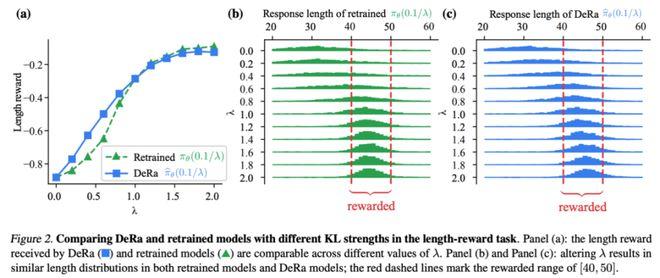

在图2基于生成长度的实验中,作者发现,通过DeRa重新对齐的模型与从头重新训练的模型表现非常相似。

3.在摘要任务上的实验

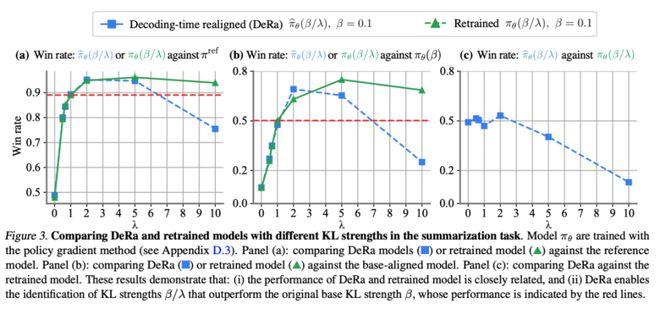

作者也验证了,我们可以使用DeRa来识别适当的正则化强度,然后只在这些值上重新训练模型,以达到降低实验开销的目的。

图3的实验结果表明,DeRa识别的KL强度β/λ优于基础KL强度β(如红线所示),这一点在摘要任务中得到了验证。

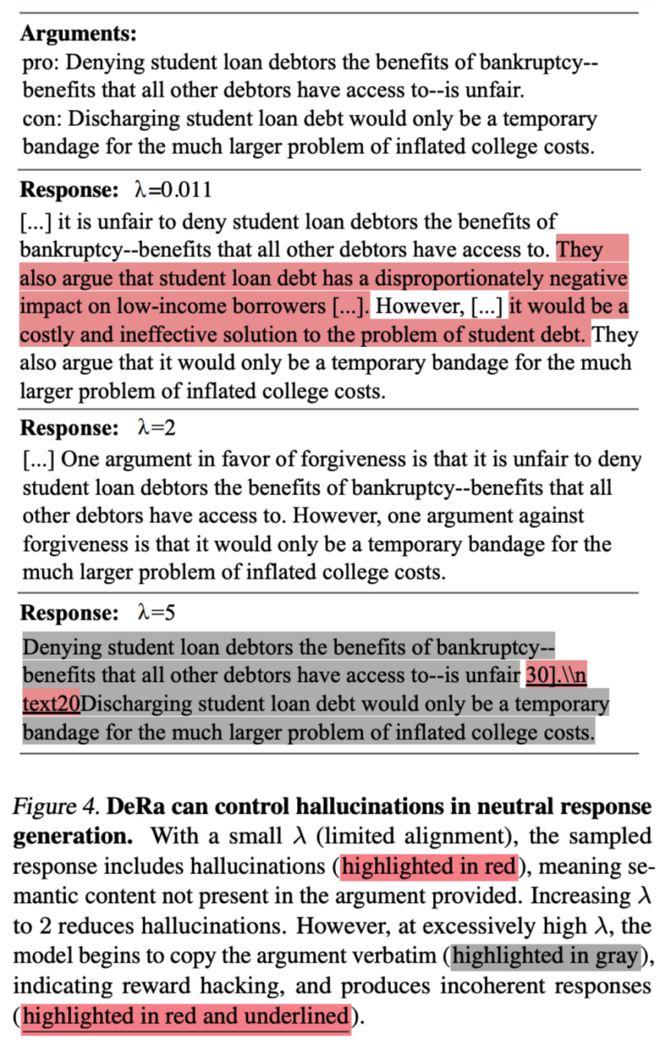

4.在幻觉消除上的任务

作者也验证了DeRa是否适用于大模型中的重要任务。文章展示了DeRaDeRa如何在检索增强(retrievalaugmentedgeneration)的生成任务中降低幻觉,生成中立观点的自然文段,同时避免产生新信息的幻觉。DeRa的可调λ允许适当的正则化,以降低幻觉,同时保持文段的流畅性。