借助前沿HBM4技术提升人工智能

来源:EETOP

人工智能(AI)和机器学习(ML)正在以非凡的速度发展,为各行各业的进步提供动力。随着模型变得越来越大和越来越复杂,它们需要实时处理大量数据。这种需求给底层硬件基础设施带来了压力,尤其是内存,它必须高速高效地处理海量数据集。高带宽内存(HBM)已成为新一代AI的关键推动因素,提供了突破AI所能实现的界限所需的容量和性能。

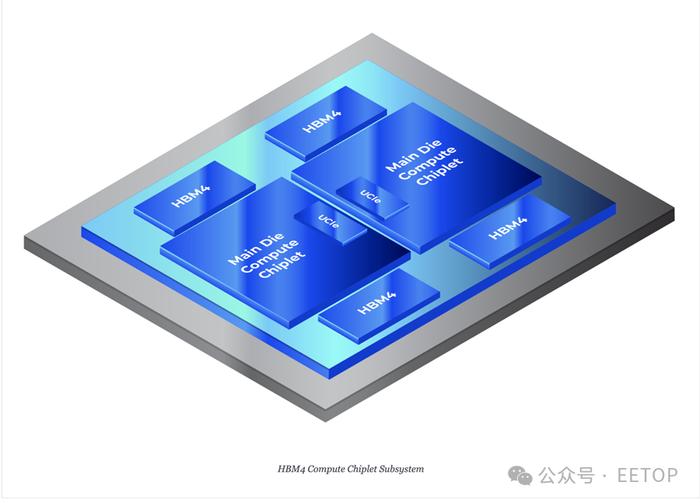

HBM技术的最新飞跃HBM4有望进一步提升AI系统。凭借增强的内存带宽、更高的效率和先进的设计,HBM4将成为未来AI进步的支柱,尤其是在自然语言处理、计算机视觉和自主系统等大规模数据密集型应用领域。

AI系统对高级内存的需求

AI工作负载(尤其是深度神经网络)与传统计算的不同之处在于,它需要并行处理大量数据集,从而带来独特的内存挑战。这些模型需要高数据吞吐量和低延迟才能获得最佳性能。高带宽内存(HBM)通过提供卓越的带宽和能效来满足这些需求。与使用宽外部总线的传统内存不同,HBM的垂直堆叠芯片和直接处理器接口最大限度地减少了数据传输距离,实现了更快的传输并降低了功耗,使其成为高性能AI系统的理想选择。

HBM4如何改进前几代产品

HBM4通过增加带宽和内存密度,显著提高了AI和ML性能。HBM4具有更高的数据吞吐量,使AI加速器和GPU能够更高效地每秒处理数百GB,从而减少瓶颈并提高系统性能。它通过向每个堆栈添加更多层来实现更高的内存密度,解决了大型AI模型的巨大存储需求,促进了AI系统的更平滑扩展。

能源效率和可扩展性

随着AI系统的不断扩展,能源效率成为一个越来越受关注的问题。AI训练模型非常耗电,随着数据中心扩展其AI功能,对节能硬件的需求变得至关重要。HBM4在设计时充分考虑了能源效率。其堆叠架构不仅缩短了数据传输距离,还降低了移动数据所需的功耗。与前几代产品相比,HBM4实现了更好的每瓦性能,这对于大规模AI部署的可持续性至关重要。

可扩展性是HBM4的另一个亮点。在保持高性能和低能耗的同时堆叠多层内存的能力意味着AI系统可以在不变得过于昂贵或效率低下的情况下进行扩展。随着AI应用程序从专用数据中心扩展到边缘计算环境,像HBM4这样的可扩展内存对于在从自动驾驶汽车到实时语言翻译系统等各种用例中部署AI变得至关重要。

使用HBM4优化AI硬件

将HBM4集成到AI硬件中对于释放现代AI加速器(例如GPU和定制AI芯片)的全部潜力至关重要,这些加速器需要低延迟、高带宽的内存来支持大规模并行处理。HBM4提高了推理速度,这对于自动驾驶等实时应用至关重要,并通过提供更高的数据吞吐量和更大的内存容量来加速AI模型训练。这些进步实现了更快、更高效的AI开发,从而可以更快地进行模型训练并提高AI工作负载的性能。

HBM4在大型语言模型中的作用

HBM4非常适合开发像GPT-4这样的大型语言模型(LLM),这些模型推动了自然语言理解和内容生成等生成式AI应用。LLM需要大量的内存资源来存储数十亿或数万亿个参数并高效处理数据处理。HBM4的高容量和高带宽能够快速访问和传输推理和训练所需的数据,支持日益复杂的模型,并增强AI生成类似人类的文本和解决复杂任务的能力。

总结

随着AI的进步,HBM4等内存技术对于解锁新功能至关重要,从自主系统中的实时决策到医疗保健和金融中更复杂的模型。AI的未来依赖于软件和硬件的改进,HBM4通过更高的带宽、内存密度和能效来突破AI性能的极限。随着AI采用率的增长,HBM4将在实现更快、更高效的AI系统方面发挥基础性作用,从而能够解决大多数数据密集型挑战。

文章来源:semiwiki

半导体技术研讨会

微电子专家、博士生导师免费授课!

特别声明:以上内容仅代表作者本人的观点或立场,不代表新浪财经头条的观点或立场。如因作品内容、版权或其他问题需要与新浪财经头条联系的,请于上述内容发布后的30天内进行。