华为与哈工深等最新研究成果:SPA-Bench,手机操控智能体评估新标准

该研究解决了现有手机智能体基准测试的局限性,为手机操控智能体的研究与评估提供标准。

随着智能手机成为人们日常生活中不可或缺的工具,手机操控智能体(smartphonecontrolagent)的研究逐渐成为大模型领域的重要方向。通过自然语言指令,这些智能体能够高效地完成复杂任务,从简单的应用打开到多步骤的跨应用操作,甚至包括多语言支持。然而,如何全面、精确地评估这些智能体的能力却始终是一个没有解决的关键问题。

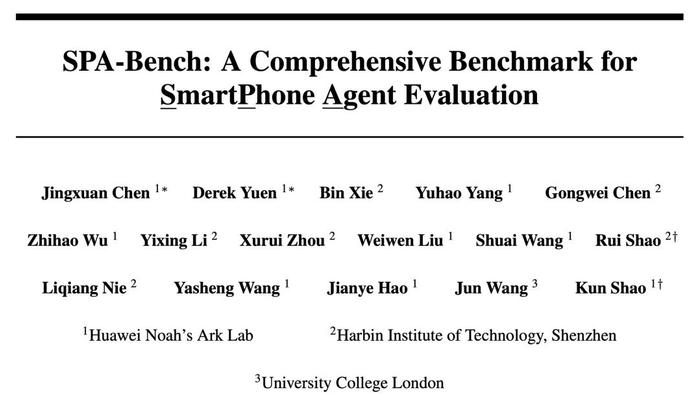

近日,华为诺亚方舟实验室与哈尔滨工业大学(深圳)联合提出了一个全新的评估框架——SPA-Bench(SmartPhoneAgentBenchmark)。这一框架旨在解决现有手机智能体基准测试的局限性,通过覆盖340个任务、支持中英双语和第三方应用操作,以及提供自动化评估流程和多维度指标,重新定义了手机操控智能体的研究与评估标准。

论文地址:arXiv:2410.15164

1

为什么需要SPA-Bench?

现有基准测试的局限性

任务范围的不足

当前的手机智能体评估框架往往聚焦于系统应用的任务,例如文件管理或日历中的简单操作。这些任务对智能体的适应能力测试非常有限,尤其是在多语言场景或动态UI环境中,其评估能力明显不足。并且,由于用户需求的多样化,很多跨应用的复杂操作(如从社交平台导出数据至笔记应用)尚未得到广泛覆盖。与此同时,虽然英语任务在现有基准中占据主导地位,但全球用户的需求显然不止于此。尤其在中文等语言场景中,UI设计、文本结构和任务逻辑的独特性对智能体提出了更高要求。然而,现有框架所涵盖的任务缺乏对此类任务的全面支持。

手机智能体种类的限制

目前大多数基准测试中涉及的智能体种类较为单一,通常不超过五种,有些研究甚至仅包含同一智能体的不同变种。这种限制使得研究者难以全面了解当前先进智能体技术的整体表现,也难以对不同模型架构的优劣进行深入对比。这不仅降低了基准测试的适用范围,也可能导致研究结论缺乏全面性,难以为智能体技术的发展提供更广泛的参考依据。

验证机制的局限性

大多数现有框架依赖人工设定的固定规则验证任务完成情况。例如,通过检测UI元素的状态来判断操作是否成功。这种方法缺乏灵活性,当UI设计或应用功能发生更新时,这些规则往往需要重新设计,导致实际评估效率降低。

2

SPA-Bench的核心设计

SPA-Bench旨在提供一个全面、灵活且贴近实际使用场景的评估框架,通过以下三个方面解决当前基准测试的痛点:

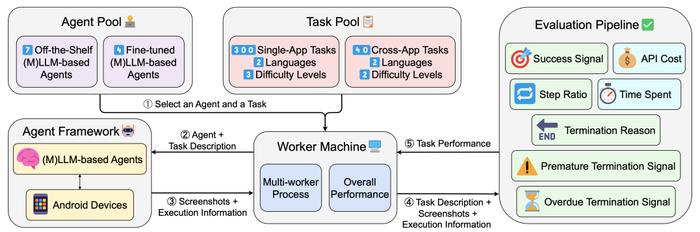

任务设计:覆盖真实场景

SPA-Bench提供了一个多样化任务集,涵盖了340个任务,分为单应用任务和跨应用任务两大类。

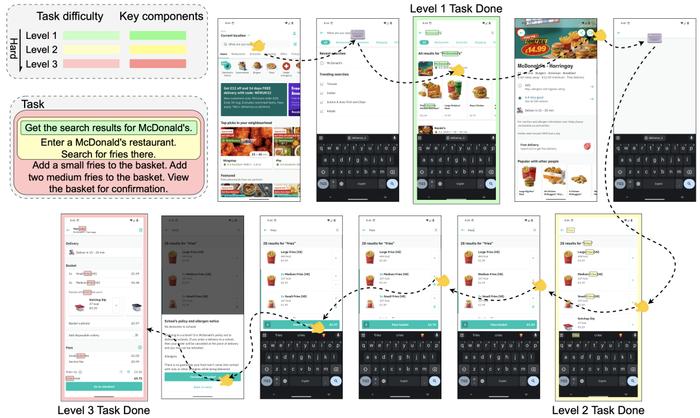

单应用任务根据复杂性被分为三个等级:

一级任务:基础且简单的活动,通常涉及少于五个操作步骤。

二级任务:引入了更复杂的需求,例如处理复杂的UI元素或动画,通常需要少于十个操作步骤。

三级任务:最复杂的任务,可能涉及多达十五个操作步骤,要求智能体处理更多步骤和逻辑依赖。

单应用任务成组出线,每个任务组内含有一、二、三级任务,任务设计相似,但通过使用不同的实体(如创建具有不同名称的文件夹)避免智能体受到早期任务的影响,确保评估的独立性和全面性。

跨应用任务基于涉及的应用数量进行难度划分:

一级任务:在两个应用之间切换完成操作。

二级任务:需要在三个应用之间进行复杂的交互,涉及更多步骤以及跨应用间的依赖与协调。

这些任务涵盖了多种类型,包括通用工具、信息管理、网络购物、媒体娱乐、社交分享和多应用协作等。跨应用任务的设计借鉴了GUIOdyssey的分类方法,并通过任务数量和操作复杂性进一步细化。

这些任务不仅涵盖了58个常用第三方应用,还支持中英双语,使得任务设计更加贴近真实世界的用户需求。

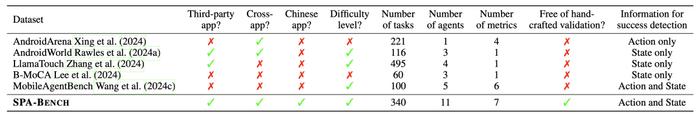

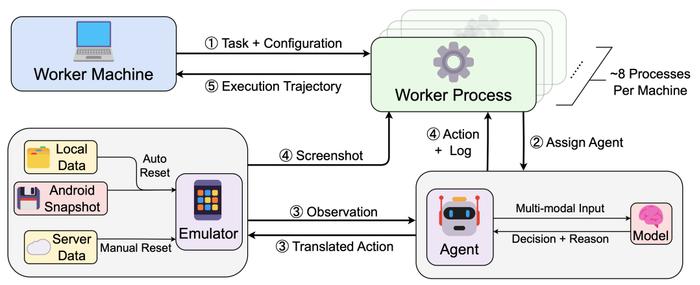

智能体框架:高度灵活的集成

SPA-Bench的框架设计允许研究者快速集成现有的智能体模型,并支持对不同模型进行横向对比。

模块化设计框架采用模块化架构,包括任务模拟器、验证流程和资源监控模块。任务模拟器可以快速恢复任务的初始环境,例如应用的登录状态、用户设置等,从而确保实验环境的一致性。

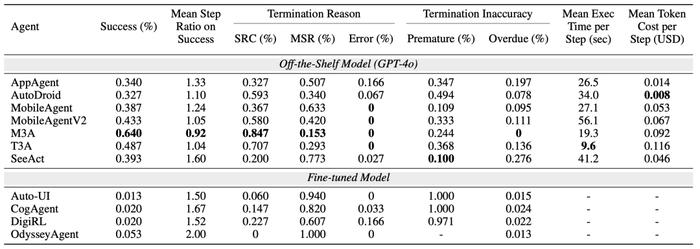

多智能体支持研究团队在SPA-Bench中已经集成了11种现有手机智能体。七种基于闭源专有模型的智能体:AppAgent、AutoDroid、MobileAgent、MobileAgentV2、M3A、T3A、SeeAct;和四种基于开源模型的智能体:Auto-UI、CogAgent、DigiRL、OdysseyAgent。

快速扩展研究者可以通过SPA-Bench快速测试新智能体,只需要做一些简单的修改即可集成。

自动化流程:高效的任务验证

SPA-Bench提供了一套全面自动化的任务验证流程,通过针对单应用任务和跨应用任务的不同设计,实现高效且精准的评估。此外,框架引入了七个关键指标,用于全面衡量智能体的表现,从完成任务的准确性到执行效率和资源消耗,为智能体的性能评价提供了多维度支持。

在评估任务完成情况时,成功信号是核心指标,用于判断智能体是否成功完成任务。结合操作和状态信息,这一指标能够适应多种有效路径,避免固定逻辑的局限性。步骤比衡量智能体的执行效率,通过对比智能体执行步骤与人工预定义的“黄金步骤”,揭示冗余操作的存在情况。终止原因进一步记录任务的结束方式,包括智能体主动终止、达到步骤限制或发生错误,同时还通过过早终止信号与超时终止信号捕捉智能体在判断任务是否完成中的逻辑偏差,反映其准确性与效率问题。此外,SPA-Bench还从资源消耗的角度,通过执行时间和API成本两个指标评估智能体的时间与经济开销,特别针对依赖大模型API的智能体进行直观的成本分析。

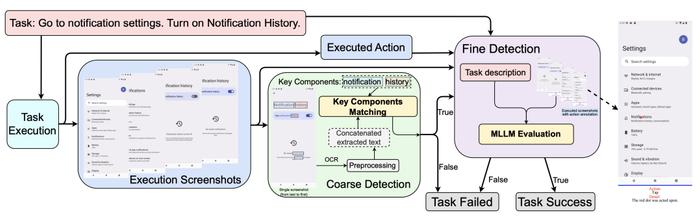

成功信号的设计在单应用任务和跨应用任务中采用了两种不同的流程,以适应任务场景的复杂性。在单应用任务中,验证流程以粗到细的检测方式为主。首先,通过关键UI元素的状态匹配实现初步筛选;随后引入大模型评估器(MLLMEvaluator),对关键步骤进行语义层面的深度检测,从而判断任务是否完成。这种方法兼顾了评估的精确性与成本效率,在英文和中文任务上的F1分数分别达到0.926和0.884,展现了出色的可靠性。

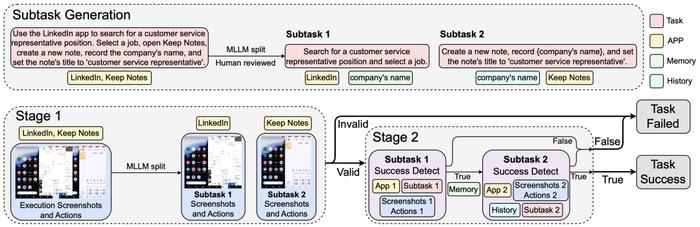

对于跨应用任务,验证流程因涉及多个应用间的交互而更为复杂。SPA-Bench采用了一种基于子任务分解的验证方法,首先通过大模型将任务轨迹根据应用来分割为多个子任务,并逐一进行验证。每个子任务的结果相互依赖,若任一子任务失败,后续验证即告终止。实验结果表明,该流程在复杂任务场景下的表现与人工评估高度一致,F1分数达到0.845,为跨应用任务的评估提供了强有力的支持。

3

实验结果与分析

任务成功率概览

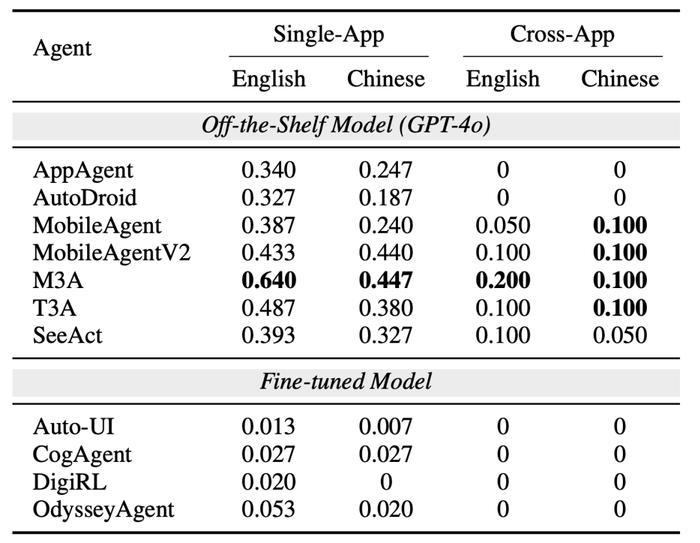

实验结果显示,不同智能体在任务成功率上的表现差异显著。M3A是整体表现最优的智能体,在所有任务组中均取得了最高的成功率。总体来看,智能体在单应用任务中的成功率高于跨应用任务,而在语言方面,英文任务的成功率也显著优于中文任务。此外,采用基于专有模型(GPT-4o)的智能体,其表现明显优于基于开源模型的智能体。

单应用任务

在单应用英文任务中,M3A、T3A和MobileAgentV2表现最佳,成功率从0.640到0.433不等。这些智能体配备了反思模块,有效减少了任务执行中的停滞现象。相比之下,AppAgent和AutoDroid的表现较差,但如果它们能够访问外部知识库,其表现可能会有所提升。

在单应用中文任务中,MobileAgentV2的表现优于T3A,且与M3A相当。这可能与T3A使用的可访问性(a11y)树结构过于复杂有关。中文任务的复杂性进一步凸显,尤其是更复杂的UI布局、频繁的动画以及干扰性元素(如广告和弹窗),这显著增加了任务执行难度。此外,由于多模态大模型在中文处理能力上的局限性,智能体在中文任务中的成功率整体低于英文任务。

跨应用任务

跨应用任务的挑战更为显著。除M3A外,大多数智能体在40项跨应用任务中的总完成数不超过4项。M3A的表现相对较好,完成了6项任务,但整体成功率仍然偏低。这类任务不仅要求智能体完成更多步骤,还需要具备在多应用间切换时保持上下文记忆的能力。然而,即使是专为跨应用任务设计的OdysseyAgent也未能成功完成这些任务。虽然其在单个应用中的子任务表现良好,但在应用间切换时常常失去上下文或逻辑推理能力。实验表明,跨应用任务的低成功率反映了智能体在多步骤任务中的记忆保留与跨环境推理能力的不足。

完成效率与资源消耗

任务完成效率和资源消耗是衡量智能体性能的重要方面。在单应用任务中,M3A的平均步骤比为0.92,显示出其在完成任务时的高效性。相比之下,面对较高难度任务的智能体往往会因错误操作而导致更多的无效步骤,尽管它们可能最终完成任务。例如,M3A能够通过组合动作(如在搜索框中输入并按下“回车”)以及策略性捷径(如直接点击推荐项)减少任务步骤,从而提升效率。

任务终止的原因也与成功率密切相关。较高的任务成功率通常伴随着更高的自报告完成率(Self-ReportedCompletion,SRC)和较低的最大步骤终止率(MaximumStepsReached,MSR)。然而,智能体并非总能准确判断任务是否完成,导致成功率与SRC之间存在差异。例如,过早终止率(PrematureTerminationRate,PTR)与超时终止率(OverdueTerminationRate,OTR)之间往往呈现权衡关系。PTR较低的智能体通常表现出较高的OTR,例如SeeAct的PTR为0.100,但OTR达到0.276。这种权衡反映了智能体内部成功检测机制的灵敏度问题,平衡任务提前终止和延迟结束的能力是优化方向之一。

错误处理机制与成本效率

智能体在任务执行中的错误处理能力对其成功率有显著影响。缺乏错误处理机制的智能体更容易因解析错误或输入缺失而中途终止任务。例如,部分智能体在解析模型输出为有效动作时遇到困难,或因无法访问必要的XML文件而导致失败。这些问题表明,更强大的错误检测与恢复机制对于提高智能体的任务可靠性至关重要。

在资源消耗方面,不同智能体的表现存在显著差异。AutoDroid是成本最低的智能体,每步消耗仅为0.008美元,但其成功率较低(0.327)且执行时间较长(平均每步34秒)。M3A和T3A的每步成本接近0.10美元,但它们具有更高的成功率和更快的执行时间(不到20秒)。MobileAgentV2的每步成本为0.067美元,但由于视觉感知流程的复杂性,其每步平均执行时间长达56.1秒。结果显示,智能体在效率与成本之间存在明显的权衡,高成功率的智能体往往需要更高的计算资源和时间成本,而这一点限制了其在实际应用中的可用性。

4

未来研究方向

增强视觉感知:开发更强大的视觉模型,提升对复杂UI布局和动态环境的理解与动作定位能力,特别是在中文任务中的表现。

丰富数据集多样性:构建包含多种语言、任务类型(单应用与跨应用)的数据集,以提高智能体在多语言和多场景下的泛化能力。

改进记忆保留机制:引入记忆增强网络或情节记忆架构,支持长步骤跨应用任务中的上下文保持与逻辑延续。

强化反思与错误处理:采用反思模块和错误恢复机制,帮助智能体动态调整策略,解决无效操作和解析错误问题。

优化任务终止判断:设计更准确的内部成功检测器,平衡过早和过晚终止,提升任务完成的效率与准确性。

提升执行效率与成本优化:通过混合模型策略,在速度与鲁棒性间找到平衡,降低任务完成时间与token成本,增强实际部署的可行性。

5

总结

SPA-Bench的提出为手机操控智能体研究提供了一个强大的工具。通过其全面的任务设计、灵活的智能体框架和高效多元的验证流程,SPA-Bench不仅填补了现有基准测试的空白,还为未来手机智能体技术的优化与发展提供了全新视角。随着社区的广泛参与和任务范围的不断扩展,SPA-Bench有望进一步推动手机智能体技术的普及与实际应用。