国内首个,北极雄芯“启明 935”系列芯粒成功交付流片

IT之家8月14日消息,北极雄芯今日官宣,该公司自主研发的启明935系列芯粒历经近2年的设计开发,已经成功交付流片。本次交付流片一次性投出两颗芯粒:

“启明935”通用型HUBChiplet

原生支持Transformer全系算子的“大熊星座”AIChiplet

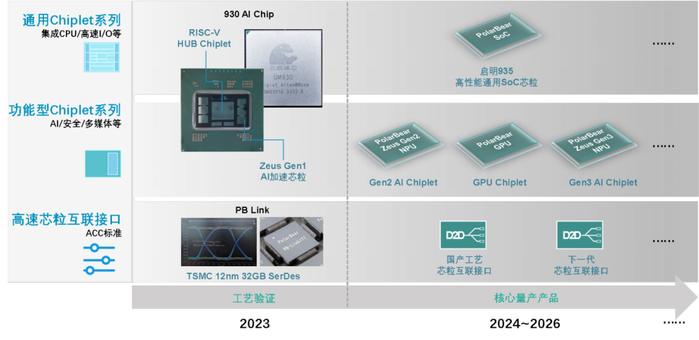

北极雄芯于2023年初完成测试并发布了国内首个基于Chiplet架构的“启明930”芯片,在国产封装供应链上成功完成了工艺验证;同年,该公司发布了首个基于国内《高速芯粒互联标准》的D2D接口PBLink。

启明935系列芯粒包括以“启明935”高性能通用HUBChiplet为核心,以及“大熊星座”AIChiplet和GPUChiplet等功能型Chiplet的芯粒家族,基于车规级要求设计,通过灵活搭配可快速生成面向自动驾驶、具身智能、AI推理加速等场景的终端产品。IT之家附两款芯粒官方介绍如下:

“启明935”高性能通用HUBChiplet:

内含多核ARMCortex-A系列CPU子系统提供核心计算能力,采用了PCIe5.0、LPDDR5等接口及存储方案,内置了北极雄芯自主研发的车规级ZeusGen2NPUCore提供AI加速算力,启明935HUBChiplet自身可作为AISoC独立使用。

除此之外,HUBChiplet中还包含视频编解码模块、ISP模块、万兆网口及MIPI接口、信息安全及功能安全模块等,符合车规级设计要求。

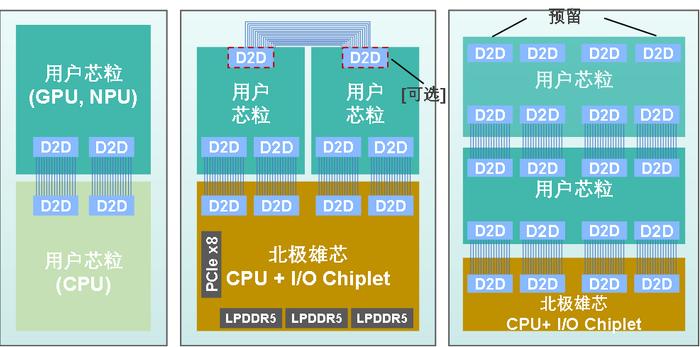

每个HUBChiplet搭载了4个独立的PBLink接口提供合计128GB/s的芯粒互联带宽,可与其他功能型芯粒拓展组合以满足不同场景差异化的功能需求以及算力拓展需求。

“大熊星座”AIChiplet:

内含多核自主研发的ZeusGen2NPUCore,不同NPUCore既可独立运行,也可联合运行加速同一任务。

原生支持Transformer全部算子,ZeusGen2NPUCore支持INT4,INT8,INT16及FP16等计算精度,支持常见的卷积层、线性层、池化层和激活层,功能上支持常用检测、分类等模型,包括但不限于VGG,ResNet,Yolo等。

支持PyTorch、TensorFlow、PaddlePaddle、ONNX等主流AI框架,在不同AI模型上实测平均利用率达到70%以上。

此外,该公司应用于智能座舱领域的GPUChiplet也在同步开发中,预计将于2025年中交付流片。

北极雄芯介绍称,基于935HUBChiplet及AIChiplet异构集成的多颗自动驾驶芯片已于2024年取得SGS以及中汽研境内外ISO-26262ASIL-B车规级双认证,是国内首个取得车规级认证的Chiplet产品,预计将于2024年底提供核心板交付下游开展适配工作。

除了应用于智能驾驶领域外,基于935HUBChiplet与AIChiplet组合的AI推理加速模组/加速卡也可应用于边缘侧及端侧AI推理应用领域(AI推理一体机、工控机、机器人等),并可支持70B的大模型推理加速。

启明 935HUBChiplet号称既可独立使用,也可作为通用型Chiplet基座进行拓展开发,将成为“国内首个兼具CPUChiplet及MemoryChiplet功能的独立通用型Chiplet”。

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。