高通骁龙X80发布:集成AI内核,支持卫星通信!

2月26日,在巴塞罗那召开的MWC2024展会上,高通技术公司带来了全面融入人工智能(AI)技术的一系列新产品,包括最新的旗舰级5G调制解调器——骁龙X80;业界首款将Wi-Fi、蓝牙和超宽带(UWB)集成到单个6nm芯片中的解决方案的FastConnect7900移动连接系统;面向开发者的全新的生成式AI模型库“AIHub”。这些新产品结合高通去年推出的面向端侧生成式AI的骁龙平台,将会为用户带来更出色的体验。

高通公司总裁兼CEO安蒙表示:混合AI是生成式AI的未来,终端侧智能与云端协同工作,能够提升个性化、隐私、可靠性和效率。连接对于助力生成式AI跨云、边缘和终端实现规模化扩展和延伸至关重要,AI解决方案正在支持高通提供下一代连接,赋能生成式AI时代。高通公司正在让智能计算无处不在,支持生态系统跨多品类终端开发并落地生成式AI用例、体验和领先产品,包括智能手机、下一代PC、XR终端、汽车和机器人等。

骁龙X805G调制解调器

据介绍,骁龙X805G调制解调器是高通第七代5G调制解调器,专为智能手机、扩展现实(XR)设备、个人电脑、车辆和工业物联网设备而设计,其特色之一是搭载了专门的AI处理器。该处理器配备了张量加速器(tensoraccelerator),可提升数据传输速度、覆盖范围和效能,并降低延迟。同时,骁龙X80还集成了第三代5GAI套件(5GAISuiteGen3),可进一步优化覆盖范围和定位精度。高通宣称,X80连接毫米波网络时,功耗可降低10%,定位精度提升30%。

骁龙X80还采用了六接收天线架构,是首个基于AI的多天线管理的5G调制解调器,也是首款支持6倍下行链路载波聚合和基于AI的毫米波范围扩展的5G调制解调器。不过,骁龙X80沿用了与骁龙X75相同的QTM565毫米波天线。

在传输速率方面,骁龙X80峰值下载速度可达10Gbps,上传速度可达3.5Gbps(理论值),支持5G毫米波(10载波聚合)和sub-6GHz(5载波聚合)频段。

此外,骁龙X80还是首款集成窄带(NB)到非地面网络(NTN)卫星通信支持的5G调制解调器,这预示着今年晚些时候,将会有更多支持卫星连接的旗舰智能手机上市。

目前,高通正在向合作伙伴提供X805G调制解调器的样品,预计搭载该芯片的商用设备将于2024年下半年上市。

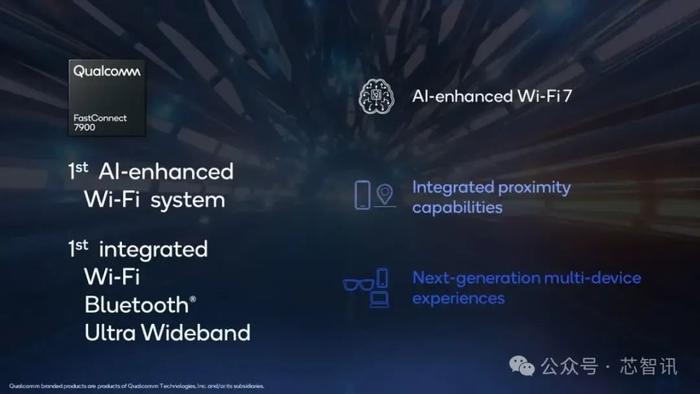

FastConnect7900移动连接系统

高通发布的FastConnect7900移动连接系统,是业界首款将Wi-Fi、蓝牙和超宽带(UWB)连接集成到单个6nm芯片中的解决方案。该系统支持最新的Wi-Fi7标准,峰值速度可达5.8Gbps,同时支持具有空间音频和ANT+功能的蓝牙5.4标准。

FastConnect7900还集成了AI技术,可根据特定用例和环境进行优化,从而降低延迟和功耗。高通宣称,FastConnect7900的功耗比上一代产品FastConnect7800低40%。

该系统还支持Wi-Fi测距和蓝牙信道探测等功能,并支持扩展个人区域网络技术(XPAN)和骁龙无缝连接(SnapdragonSeamless)。后者可将运行不同操作系统的多个设备进行连接,并实现智能音频切换和设备邻近发现。

FastConnect7900的Wi-Fi芯片还支持高频段并发(HBS)标准,可在设备和配件之间实现低延迟的即时连接。

高通透露,预计FastConnect7900将于2024年下半年商用上市。

AIHub

继去年高通推出了支持端侧AI大模型的骁龙处理器平台之后,为了进一步助力端侧AI应用的落地,高通在此次MWC2024展会上正式推出了全新的高通AIHub,为开发者打造获取开发资源的中心,让消费者能够在搭载骁龙8系移动平台的终端上轻松获取生成式AI体验。

高通技术公司高级副总裁兼技术规划和边缘解决方案业务总经理马德嘉表示,借助高通AIHub,将赋能开发者充分发挥这些前沿技术的潜力,打造具有吸引力的AI赋能应用。高通AIHub为开发者提供了一个全面的AI模型库,使他们能够轻松快速地将预优化AI模型集成进应用程序,从而打造更快、更可靠且更具隐私性的用户体验。

首先,开发者可以选择应用所需的模型,以及其开发应用所使用的框架。下一步,开发者需要确定他们的目标平台,例如一款特定型号的手机、或者一款特定型号的高通平台(例如第三代骁龙8)。确定以上信息后,高通AIHub就可以为开发者提供面向其指定应用、指定平台进行优化的模型。开发者只需要几行代码就可以获取模型,并将模型集成进应用程序。

据了解,高通AIHub将支持超过75个AI模型,包括传统AI模型和生成式AI模型。通过对这些模型进行优化,开发者运行AI推理的速度将提升高达4倍。不仅是速度提升,优化后的模型占用的内存带宽和存储空间也将减少,从而实现更高的能效和更持久的电池续航。这些优化模型将在高通AIHub、以及HuggingFace和GitHub上提供,让开发者能够将AI模型便捷地集成到工作流中。

HuggingFace联合创始人兼CEO表示,这些主流AI模型面向终端侧机器学习而优化,并且可在骁龙和高通平台上使用,将赋能下一代移动开发者和边缘AI应用,让AI进一步惠及所有人。

编辑:芯智讯-林子