这个团队深耕车路协同,要给无人车开启“全知视角”

转自:荔枝网

荔枝新闻编辑/胡逸乔2019年,无人驾驶汽车似乎遇到了“减速带”,整体技术突破不大,各品牌纷纷推迟产品发布。甚至有业界大佬悲观地表示,“全自动驾驶汽车在我有生之年无法实现”。

那一年的苏州,一家名为“艾氪英诺”的机器人科技公司刚成立,清华大学、浙江大学、电子科大的几个年轻博士组团创业,想在无人驾驶领域“搞点不一样的大事”。他们的定位是“路脑”,简单理解为,让道路聪明的“大脑”。

在2022年科大讯飞AI开发者大赛上,艾氪英诺团队展现了他们的“路脑”产品如何通过车路协同赋能自动驾驶,以及给智慧交通带来的新可能。

多源数据前融合,让无人车拥有“上帝视角”

“现在说的无人驾驶都是‘单车智能’,可单车就像座数据孤岛,哪怕再‘智慧’,装再多的传感器、激光雷达、摄像头,也很难全局无死角感知。”艾氪英诺联合创始人袁飞说。

比如,经过路口时前面有一辆大卡车,仅靠无人车的“火眼金睛”,无法知道从大卡车的某侧,会不会跑过来一个行人,更无法知道,视野之外的逆行、闯红灯行为,甚至是还有点距离但可能会波及驾驶人的连环车祸。

无法保障交通安全,无人车行业谈何进入深水区。

如果给无人车开个“上帝视角”,全局掌握车辆周边不安全隐患,即便极端天气、不利照明、物体遮挡等条件下也能准确判断,那就安全多了。袁飞说:“路脑”就是这个‘上帝视角’,通过路侧全时空、多场景、全要素的信息采集和处理,为无人车提供全息感知。”

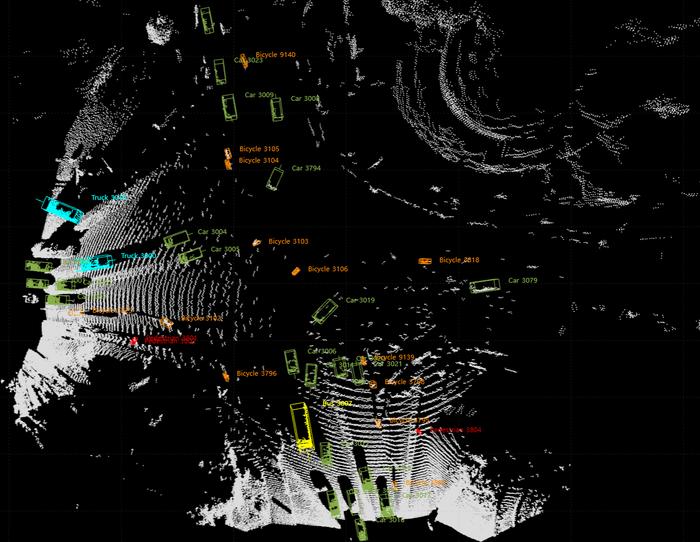

通过在路端部署摄像头、激光雷达、毫米波雷达等传感器获得“上帝视角”的路口

有“智慧的车”还要有“聪明的路”,形成车与路、车与车的高度协同,才能实现真正的“高自主”无人驾驶。作为车路协同的细分领域,路侧智能的价值广为人知,但投身研发去“铺路”也绝非易事。

与车路协同的车端、云端相比,路端更依赖算法来体现出核心价值,越“聪明”的路“算力”和“算法”当然要更强。

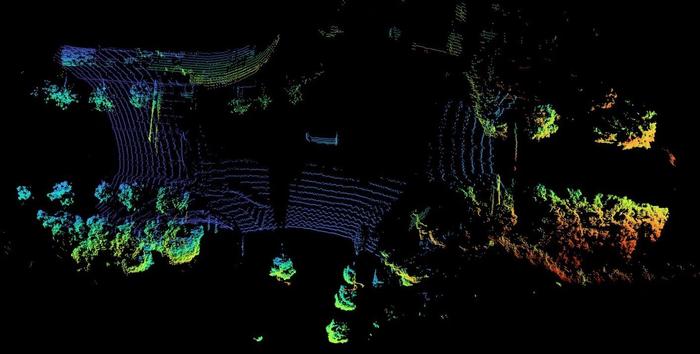

“路脑”包括感知和决策,首先要将基于雷达、摄像头等路侧感知设备所采集的原始数据,在自身的算法平台上进行融合。

艾氪英诺通过自研算法,实现摄像头2D图片数据和激光雷达3D点云数据融合,提高对交通参与者类型的识别

“与单车相比,路侧会产生大量不同格式的数据,这对多源数据的融合提出了更高的要求。”袁飞说,只有在感知精度和推理速度上同时达到一定的标准,才能为无人驾驶提供快速准确的决策支持。

按照已有的解题思路,是根据感知模块提取的特征,进行多源数据的后融合。但艾氪英诺选择的技术路径是“前融合”,在同一点上同时处理来自激光雷达、摄像头、毫米波雷达等多个维度的原始数据,实现多源数据的时空同步和协同感知。

“这个方式的技术门槛很高,对算法和算力都是极大考验,但能用更少的定制化和更低的部署成本,采集足够多的路侧感知数据,实现更高的准确率、更快的决策分析。”袁飞说。在团队看来,“前融合”不仅在路侧,在车端也有一定优势。他表示,未来,前融合应该是更主流的方案。

“路脑”让交通出行更智慧

一条“聪明的路”,从“大脑”到“毛细血管”的指挥要更顺畅,得有及时、高效、可靠的“事前预判”硬实力,对影响正常行车的突发事件,进行短时预测、预警预告。

通过算法优化和针对芯片的底层加速,艾氪英诺“路脑”实现了边缘端更低的推理延迟和部署算力要求。袁飞说:“决策、传达一个行车指令,通过我们的技术只要50毫秒就行,比‘一眨眼’的速度还要快。”

不断对技术攻关、创新,在交通流量提取、事故识别、特征分析及短时预测等方面,艾氪英诺建立起了一套领先的交通感知、决策算法。

交通拥堵、道路施工、车辆慢行、异常实线变道、超速、占用应急车道、行人横穿……“路脑”可对各种机动车、非机动车和行人进行交通信号、交通隐患、交通事件、交通流量等数十种场景的实时感知和智能分析,让“智慧出行”有了“眼观六路”的能力。

目前,“路脑”已在常熟、西安、长沙等城市应用,打造了多个“全息路口”,动态获取路口车流量状态,计算分析出交通演变的规律。艾氪英诺希望,尽快推进“路脑”在布局智能网联汽车的封闭园区落地,搭建车、路协同的桥梁,让“真无人”车安全地跑起来。

11月17日,第五届世界声博会暨2022年科大讯飞全球1024开发者节在合肥开幕。像艾氪英诺这样的团队有3万多个,他们以人工智能技术为武器,去解决大时代下的每个社会命题,一同推动数字经济发展。