大涨6.45%!交换机龙头打脸英伟达,谁说以太网不行?

大涨6.45%!交换机龙头打脸英伟达,谁说以太网不行?

交换机龙头Arista在财报会上提到,其与Broadcom合作的AI集群数据显示,Arista的以太网产品,相比英伟达的InfiniBand,完成速度至少提高了10%。

本文作者:张逸凡

来源:硬AI

1、Arista:以太网算力集群网络超预期,大涨6.45%

InfiniBand和以太网是两种通信协议。因为InfiniBand传输速度快、性能好,被英伟达收购后大量应用于云厂商的数据中心。反观以太网,因为速度慢,数据丢失等问题,一直未能服务于AI数据中心。因此,市场一度认为,AI领域唯有InfiniBand。

然而,交换机龙头Arista在昨日的会议上,否认了这个说法。

就在昨日Arista的财报会上,公司表示Meta今年三月推出的两个超大规模算力集群中,有一个使用的是Arista的以太网产品。

该网络连接了2w4个H100GPU,且性能完全不逊色于Infiniband。参考8000张H卡可以训练一个GPT-4模型,2w4张H100GPU的集群规模可以适用于各种场景,意味着以太网络的性能完全能够达到AI算力集群的需求。

公司预计2025年可以连接1万到10万个GPU。

另外,公司表示其与Broadcom合作的集群数据显示,Arista的以太网产品,相比传统的InfiniBand,作业完成速度至少提高了10%。这与先前市场一直认为的以太网络性能不及InfiniBand完全相反。

24Q1业绩会财务数据:

FY24Q2营收指引16.2-16.5亿美元(一致预期16.2亿),Non-GAAP毛利率约64%(一致预期62.5%),Non-GAAP营业利润率约44%(一致预期42.9%);

指引2024年全年的营收增速将高于先前交流的10-12%;

2、ARM:与Meta类似,FY25指引不及预期,盘后大跌9%

AI高增速背景下,市场给予了ARM强预期。参考前阵子Meta因指引不及预期的大跌,Arm必须提供超预期的业绩和预测,才能够避免这种情况。

然而ARM在本周的财报会上给出的FY25指引并未能及预期,致盘后下跌9%。

由于ARM——

与英伟达签署了长达20年新协议,授权GraceCPU(配套英伟达的算力卡一起出货);

与亚马逊、微软、谷歌等云厂商合作开发自研数据中心CPU芯片,供货云巨头AI服务器;

因此,ARM在AI数据中心的份额逐步提升。叠加近期Meta、谷歌、微软的超预期资本开支,市场本预期ARM维持高增速,然而FY25指引不及预期,导致盘后大跌。

24Q1业绩会财务数据:

FY25Q1:收入8.75-9.25亿美元,yoy+29.6%-37.0%(一致预期8.70亿美元);

FY25:收入38.0-41.0亿美元,yoy+17.5%~26.8%(一致预期40.25亿美元);

3、Citi:英特尔在微处理器的市场份额被AMD、ARM挤占

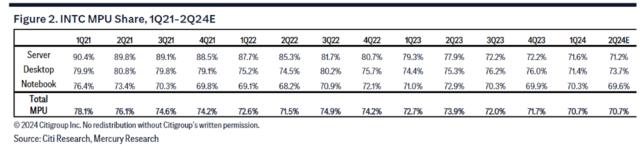

英特尔2023年推出“四年五节点”战略,旨在夺回自己处理器的龙头地位。但最新数据显示,战略实施的并不是很顺利。

根据Citi报告,24Q1最新数据显示,英特尔在服务器、台式机和笔记本电脑等各个领域都正在被AMD和ARM挤占:

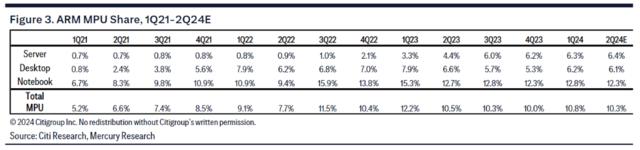

ARM:在所有领域(包括笔记本电脑、台式机和服务器)的市场份额都在稳步增长,主要是由于ARMCPU的高性能+低功耗的特点,赢得了市场的认可;

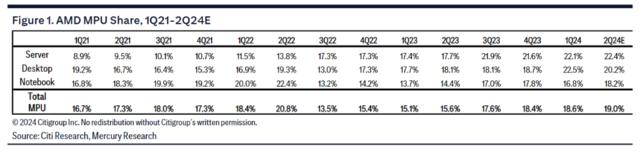

AMD:市场份额增长,尤其在服务器和台式机CPU市场,仅笔记本电脑市场份额略微下降,主要是因为其进军“高端芯片”的战略获得了成功;

英特尔:总体上看,在所有领域的市场份额在减少,能看出英特尔还未从先前战略实施错误的阴影中走出来;

因此,尽管英特尔在去年喊出了响亮的口号并制定了激进的公司战略,也推出了7nm制程的Ultra系列处理器和AIPC的Lake系列处理器。但最新数据来看,公司暂未迎来转折。

ARM——

AMD——

英特尔——

4、美银:AIPC处理器的竞争越发激烈

报告预测了AIPC市场增长,认为到2027年将从目前的5000万台增长到1.67亿台。2023年全球PC出货量约为2.47亿台,相当于2027年近67.6%的电脑出货是AIPC。

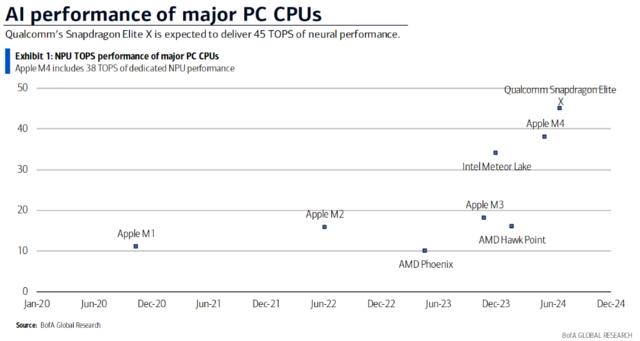

此外,美银对目前市场上已经发布的AIPC处理器做了性能排序:

从图中可以看到,苹果此次发布的M4芯片性能仅次于高通骁龙X,但领先于英特尔最新发布的Lake系列。

最后,报告中强调了内存在AI进步中的重要性,认为更大的AI模型需要更大、更快、更节能的内存,这将使美光等公司受益。

本文来自微信公众号“硬AI”