英伟达发布Blackwell架构GPU:包括B200和GB200,大幅提升AI计算性能

在美国加州圣何塞会议中心举行的GTC2024大会上,英伟达创始人兼CEO黄仁勋英伟达创始人兼CEO黄仁勋带来了Blackwell架构GPU,包括用于取代H100/H200的B200GPU,另外还有与GraceCPU相结合的GB200。

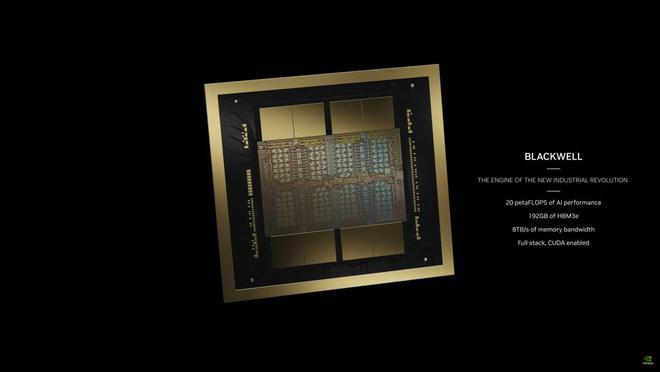

B200采用了台积电(TSMC)改进的4NP定制工艺制造,整合了两个独立制造的Die,共有2080亿个晶体管,将使用新的NVLink5.0技术来连接两块芯片。其拥有160组SM,对应20480个核心,搭配的使192GB的HBM3E,提供了高达8TB/s的带宽,功耗达到了700W。B200单个GPU提供了20petaflops的AI性能,大概五倍于H100的4petaflops。由于引入了第二代Transformer引擎,将有助于自动将模型转换为适当的格式以达到最佳性能。此外,Blackwell架构GPU还支持新的FP6格式,这是一种介于FP4和FP8两者之间的解决方案。

暂时还不清楚台积电4NP工艺的细节,但密度方面应该不会有明显的提升,而之前的H100基本上已经是一个完整的掩模版,芯片尺寸为814mm2,而理论最大值为858mm2。为此B200使用了两个全尺寸掩模版制造的芯片,每个对应四个HBM3E堆栈,每个堆栈的接口为1024-bit、容量为24GB、带宽为1TB/s。相比之下,每个H100芯片对应六个HBM3接口,意味着B200每个芯片可以减少内存控制器所需要的芯片面积,从而将更多的晶体管用于计算单元。此外,用于两个芯片互连的NV-HBI接口也会占用一些空间。

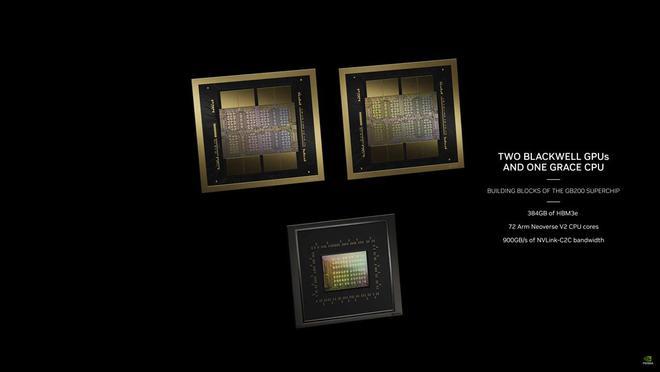

英伟达的Superchip被设计为人工智能(AI)和高性能计算(HPC)工作负载的典型平台,这次将Blackwell架构GPU与GraceCPU结合推出了GB200GraceBlackwellSuperchip。其配备了两个B200GPU和一个GraceCPU,后者配有72核心的ArmNeoverseV2内核,可配置TDP高达2700W。新平台提供了40PetaFlops的计算性能(INT8),并拥有864GB的庞大内存池,HBM3E具有16TB/s的内存带宽,芯片之间通过3.6TB/s带宽的NVLink进行互连。

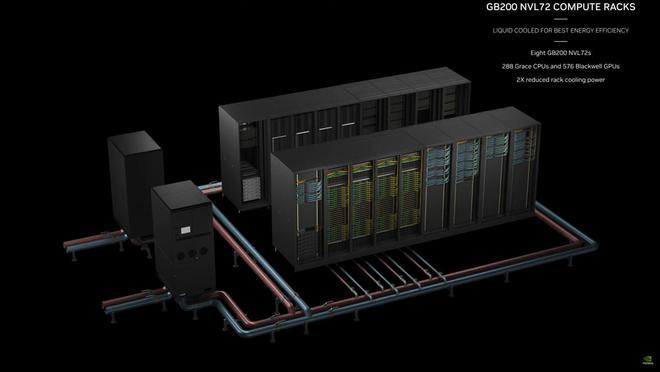

英伟达还带来了全新的GB200NVL72计算平台,这是一个全机架解决方案,有18个1U服务器。其提供的FP8性能为720petaflops,FP4计算性能为1440petaflops,可处理多达27万亿个AILLM参数模型。每台服务器里带有两个GB200GraceBlackwellSuperchip,合计共有36个GraceCPU和72个BlackwellGPU。这些计算节点带有1.7TB的HBM3E内存、32TB/s的内存带宽,并且全部采用液冷MGX封装。

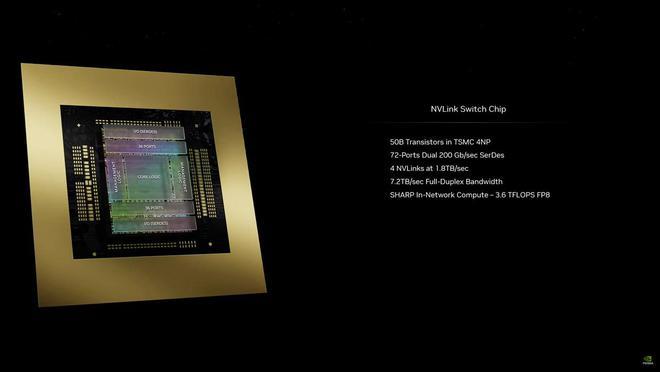

每个机架内还有ConnectX-800GInfinibandSuperNIC,以及一个用于网络内计算的Bluefield-3DPU(80GB/s内存带宽)。另外还会有最新的NVLINK交换机,具有8个接口,速率为1.8TB/s,总带宽高达14.4TB/s。英伟达还推出了新款NVLinkSwitch芯片,拥有500亿个晶体管,采用了台积电4NP工艺制造,提供了7.2TB/s带宽,用于不同节点之间的通信互连。

英伟达通过八个GB200NVL72计算平台,组成了新的DGXSuperPOD,合计共有288个GraceCPU和576个B200GPU。这本身就是一台AI超级计算机,具有240TB内存,提供了11.5exaflops的FP4计算能力。

英伟达通过发布Blackwell架构GPU,再次巩固了自身在人工智能市场的主导地位,开创了AI计算的新时代。Dell、思科、HPE、联想、Supermicro、Aivres、华擎、华硕、Eviden、富士康、技嘉、英业达、和硕、云达、纬创、Wiwynn和ZTSystems等OEM厂商也将在未来提供各自的解决方案。