ICML 2024|Transformer究竟如何推理?基于样例还是基于规则

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

文章第一作者为来自北京大学物理学院、即将加入人工智能研究院读博的胡逸。胡逸的导师为北京大学人工智能研究院助理教授、北京通用人工智能研究院研究员张牧涵,主要研究方向为图机器学习和大模型的推理和微调。

论文地址:https://arxiv.org/abs/2402.17709

项目主页:https://github.com/GraphPKU/Case_or_Rule

论文标题:Case-BasedorRule-Based:HowDoTransformersDotheMath?

Case-basedorrule-based?

尽管如ChatGPT这样的大语言模型(LargeLanguageModels,LLMs)已经在各种复杂任务中展现出令人惊艳的性能,它们在处理一些对人类来说十分简单的数学推理问题时仍会面临困难,例如长整数加法。

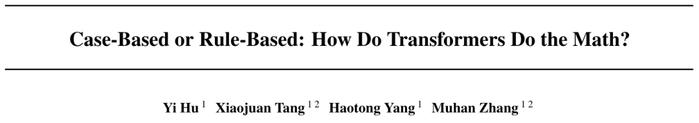

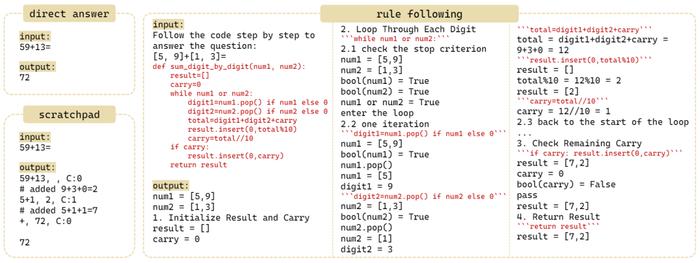

人类可以轻松地学习加法的基本规则,例如竖式加法,并将其应用于任意长度的新的加法问题,但LLMs却难以做到这一点。相反,它们可能会依赖于训练语料库中见过的相似样例来帮助解决问题。来自北京大学张牧涵团队的ICML2024论文深刻研究了这一现象。研究者们将这两种不同的推理机制定义为“基于规则的推理”(rule-basedreasoning)和“基于样例的推理”(case-basedreasoning)。图1展现了两种推理机制在遇到同一个加法问题时,采用的不同模式。

由于rule-basedreasoning对于获得系统性的泛化能力(systematicgeneralization)至关重要,作者在文章中探讨了transformers在数学问题(例如"")中到底是使用何种推理机制。为了测试模型是否依赖特定样例来解决问题,作者使用了Leave-Square-Out方法。主要思想是首先需要定位模型可能依赖的训练集中的样例,然后将它们从训练集中移除,以观察它们是否影响模型的测试性能。对于数学推理,作者的假设是,在解决某个测试样本时,transformers倾向于依赖与测试样本“接近”的训练样本来进行推理。因此,作者在样本的二维空间中挖掉了一块正方形作为测试集(testsquare)。根据假设,若模型在做case-basedreasoning,且模型依赖的是与testsample距离较近的trainingsample来做推理,那么模型将无法答对正方形中心附近的testsamples,因为模型在训练集中没有见过接近的样例。

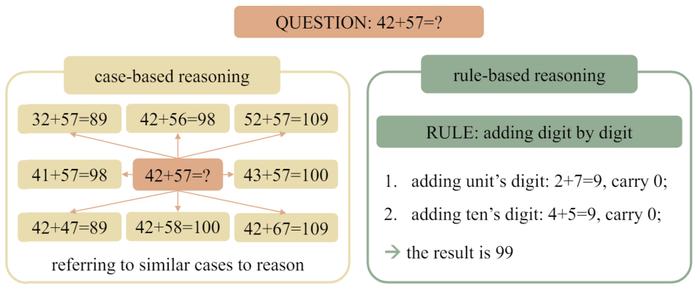

图2:GPT-2在加法、模加法、九进制加法、线性回归上利用Leave-Square-Out方法进行fine-tune后在全数据集上的正确率。其中,红框中的方形区域为测试集,其他部分为训练集合。

通过在五个数学任务(包括加法、模加法、九进制加法、线性回归以及鸡兔同笼问题)的干预实验,transformers无一例外都表现出了case-basedreasoning的行为。作者利用Leave-Square-Out方法对GPT-2进行了fine-tune,具体的模型表现展示于图2。可见,测试集内,模型的性能由边界到中心迅速下降,出现了holes。这说明当我们把holes周围的similarcases移出训练集时,模型便无法做对holes中的testsamples做出准确推理。也即展现出模型依赖similarcases进行推理的行为。为了确保结论的公平性,作者同时利用randomsplit方法对数据集进行了训练集/测试集的划分,并观察到randomsplit下模型可轻易在测试集上达到接近100%的准确率,说明Leave-Square-Out实验中的训练样例数是足够模型完成推理的,且再次侧面印证了transformers在做基于样例的推理(因为randomsplit下所有testsamples都有接近的trainingsamples)。

Scratchpad是否会改变模型推理行为?

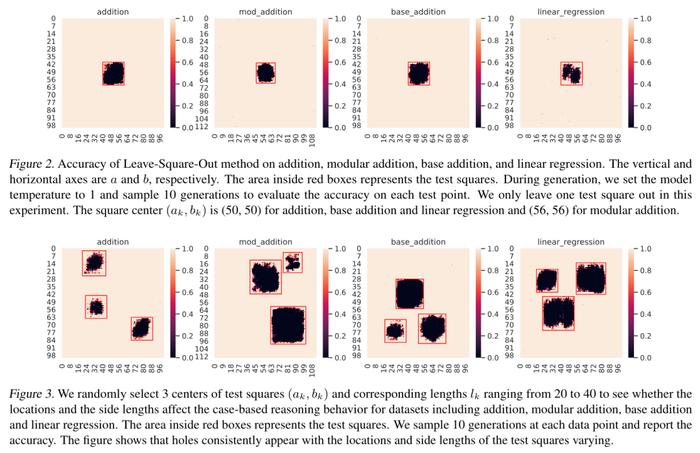

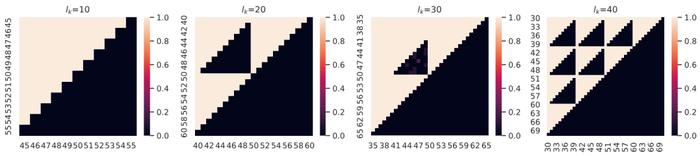

此外,作者探讨了是否可以通过加入scratchpad,即引导模型在输出中一位一位地做加法来消除case-basedreasoning的行为,使模型转向rule-basedreasoning(scratchpad的具体方法可见图4)。图3展示了利用scratchpad对GPT-2在加法任务上进行fine-tune后的模型在testsquare中的准确率。

一方面,可发现testsquare中仍然有一部分模型无法做对的区域,表现出模型仍然在做case-basedreasoning;另一方面,与不加入scratchpad时模型在testsquare中出现整块连续的hole的现象相比,模型在使用scratchpad时对于训练样例的依赖情况显然发生了变化。

具体而言,testsquare中无法做对的区域呈现为三角形,其斜边沿着个位和十位的“进位边界”。例如,图3中自左向右第2张图(testsquare边长)有两个三角形区域,模型的准确率几乎为零。小三角形表示,模型无法解决如的问题,因为训练集中没有包含十位上的步骤(所有四十几+四十几的样例都在测试集中)。而对于不涉及十位进位的测试样本,如,模型则能够成功,因为它可以从大量其他训练数据中学习到这个中间步骤(例如)。对于大三角形中的数据而言,模型无法解决例如这样的问题,因为训练集中没有包含十位上需要进位到百位的案例。

这些黑色区域的形状和位置表明,只有当测试案例的每一步在训练集中都出现过时,模型才能够成功;否则就会失败。更重要的是,这一现象表明,即使有step-by-step的推理过程的帮助,transformers也难以学会rule-basedreasoning——模型仍然在机械地记忆见过的单个步骤,而没有学会背后的规则。

其他影响因素

Scratchpad以外,作者也在文章中对testsquare的位置、大小,模型的大小(包括GPT-2-Medium,与更大的模型:Llama-2-7B和GPT-3.5-Turbo),数据集的大小等因素进行了丰富的测试。模型在做case-basedreasoning的结论是统一的。具体的实验细节可见文章。

Rule-FollowingFine-Tuning(RFFT)

通过上述的干预实验,作者发现transformers在数学推理中倾向于使用case-basedreasoning,然而,case-basedreasoning会极大地限制模型的泛化能力,因为这意味着模型如果要做对新的testsample,就需要在训练集中见过相似的样本。而在训练集中覆盖到所有未知推理问题的相似样本是几乎不可能的(尤其对于存在长度泛化的问题)。

图4:directanswer,scratchpad与rule-following三种方法的input-outputsequence

为了缓解此类问题,作者提出了名为Rule-FollowingFine-Tuning(RFFT)的规则遵循微调技术,旨在教transformers进行rule-basedreasoning。具体来说,如图4所示,RFFT在输入中提供显式的规则,然后指导transformers逐行地回忆规则并执行。

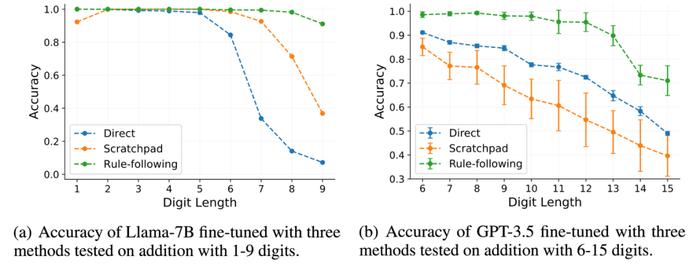

实验中,作者在1-5位数的加法上使用图4所示的三种方法对Llama-2-7B和GPT-3.5-turbo进行了fine-tune,并分别在6-9与6-15位数的OOD的加法任务上进行了测试。

由图5可见,RFFT在长度泛化的性能上明显超过了directanswer和scratchpad这两种微调方法。使用Llama-2-7B进行RFFT时,模型在9位数的加法中也能保持91.1%的准确率。相比之下,使用scratchpad进行fine-tune的模型在此任务中的准确率不到40%。对于拥有更强的基础能力的GPT-3.5-turbo,RFFT使其能够惊人地泛化到涉及多达12位数字的加法,尽管只在1-5位加法上训练了100个训练样本,但其在12位数的加法上仍然保持了95%以上的准确率。这也显著超过了scratchpad和directanswer的结果。这些结果突出显示了RFFT在引导transformers进行rule-basedreasoning方面的有效性,并展现了其在增强模型长度泛化能力方面的潜力。

值得注意的是,作者发现Llama-2-7B需要150,000个训练样本才能泛化到9位数字,而GPT-3.5仅用100个训练样本就能掌握规则并泛化到12位数字。因此,规则遵循(rule-following)可能是一种metalearningability——它可能通过在多样化的rule-following数据上进行训练而得到加强,并可更容易地迁移到新的未在训练集中见过的领域中。相应地,基础模型越强大,理解并学习新的规则就越容易。这也与人类学习新规则的能力相符——经验丰富的学习者通常学习得更快。

总结

本文探究了transformers在做数学推理问题时究竟是采用case-basedreasoning还是rule-basedreasoning,并提出了Rule-FollowingFine-Tuning的规则遵循微调方法来显式地教会transformers进行rule-basedreasoning。RFFT展现了强大的长度泛化能力,并有潜力全面提升LLMs的推理能力。